Moraes não defendeu a proibição da “linguagem golpista” dos evangélicos; áudio foi gerado por IA

- Publicado em 12 de dezembro de 2025 às 20:43

- 2 minutos de leitura

- Por AFP Brasil

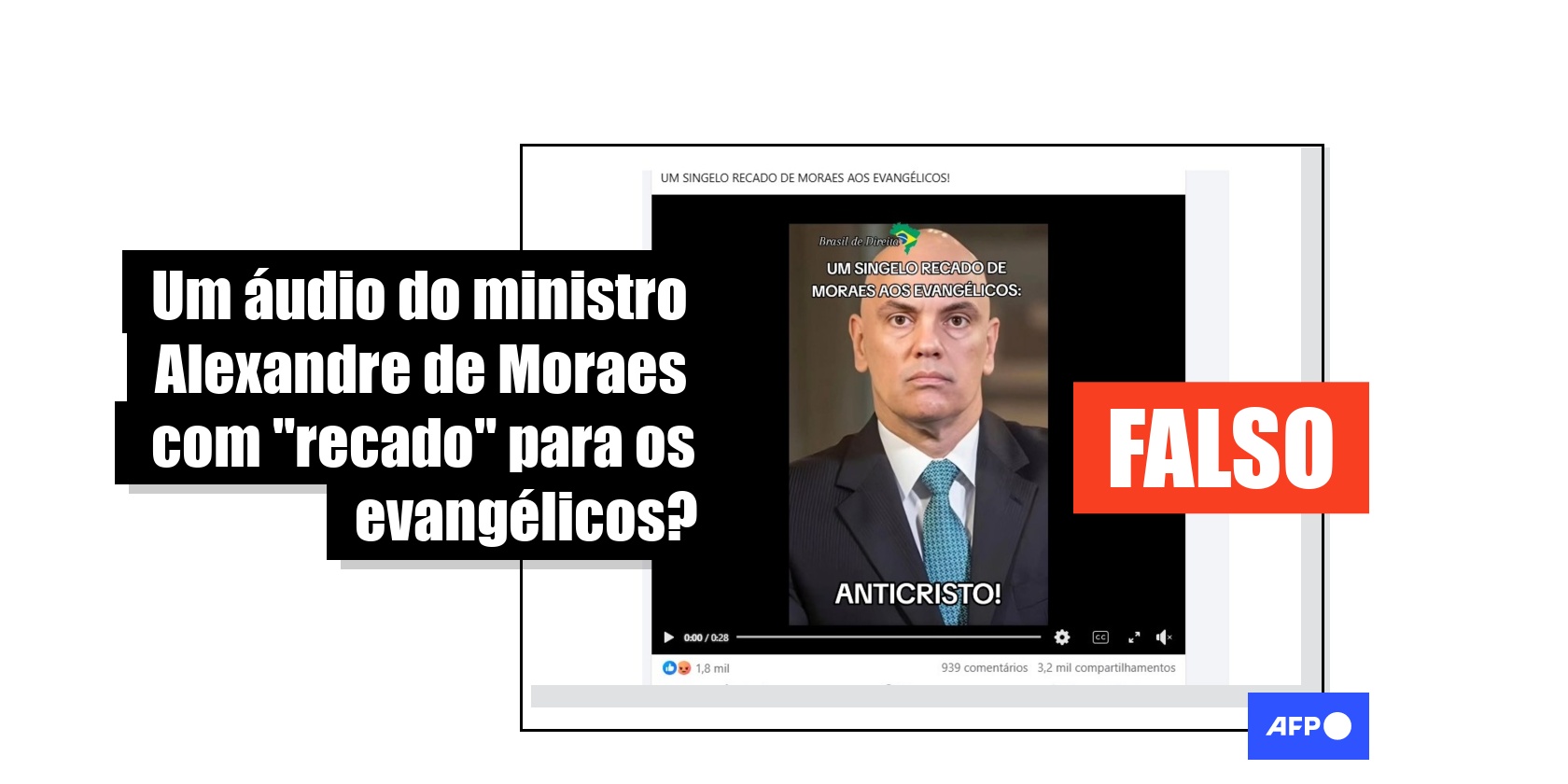

O ministro do Supremo Tribunal Federal (STF) Alexandre de Moraes continua sendo alvo recorrente de desinformação nas redes sociais. Ao contrário do que afirmam publicações que somam mais de 320 mil interações desde 6 de dezembro de 2025, um áudio viral não mostra o magistrado dizendo que pretende proibir “o vocabulário golpista dos evangélicos”. O material foi criado por inteligência artificial (IA) e não há nenhum registro de uma fala do ministro com este teor.

“UM SINGELO RECADO DE MORAES AOS EVANGÉLICOS!”, dizem publicações que acompanham a gravação no Facebook, no Instagram, no TikTok, no Threads e no Kwai.

No áudio viral, Moraes supostamente diz: “Temos que acabar com o vocabulário golpista dos evangélicos. Proibir falas como ‘o Senhor dos senhores’, ‘o Senhor dos exércitos’, ‘único Deus’, “único que é digno” e outras tantas que ofenda essa Corte Suprema. Nós é que somos Supremos. A Justiça é feita aqui, nesse tribunal. Não vamos admitir que haja outra Justiça, além da nossa”.

Mas não se trata de uma fala autêntica do magistrado.

O AFP Checamos realizou buscas por palavras-chave no Google com os termos “Alexandre de Moraes”, “proibição” e “vocabulário golpista dos evangélicos”, que não levaram a resultados correspondentes da suposta fala do ministro nem a registros da repercussão nos meios de comunicação.

O Comprova, projeto de verificação colaborativa do qual a AFP faz parte, submeteu a gravação à ferramenta de detecção de IA Hiya, do plugin de verificação digital InVid-WeVerify, que apontou 93% de probabilidade do áudio ser gerado por IA.

Procurado pelo Comprova, o consultor em inteligência artificial Pedro Burgos destacou alguns elementos que indicam a manipulação. Por exemplo, o fim das frases nem sempre é pontuado, “o que é um problema comum de modelos geradores de áudio”, disse Burgos.

O especialista indicou que o ritmo da fala e a ausência de pausas para respirar também constituem indícios do uso de IA. “Tem o problema que a acústica da voz fake é meio constante, como se estivesse no vácuo, não tem algo como um eco de uma sala”, acrescentou.

Em 2025, o AFP Checamos já verificou outras postagens semelhantes, mostrando áudios de personalidades gerados por IA (1, 2).

Este texto faz parte do Projeto Comprova. Participaram jornalistas do Estadão. O material foi adaptado pelo AFP Checamos

Referência

Copyright © AFP 2017-2026. Qualquer uso comercial deste conteúdo requer uma assinatura. Clique aqui para saber mais.